OpenAI desplegó recientemente una nueva actualización, que permite que las versiones móviles de ChatGPT puedan razonar a través de audio y visión en tiempo real, como si tuviera “ojos”. Presentada en mayo de 2024, los usuarios con perfiles Plus ya pueden acceder a esta funcionalidad, que le permite al chatbot interactuar con el entorno.

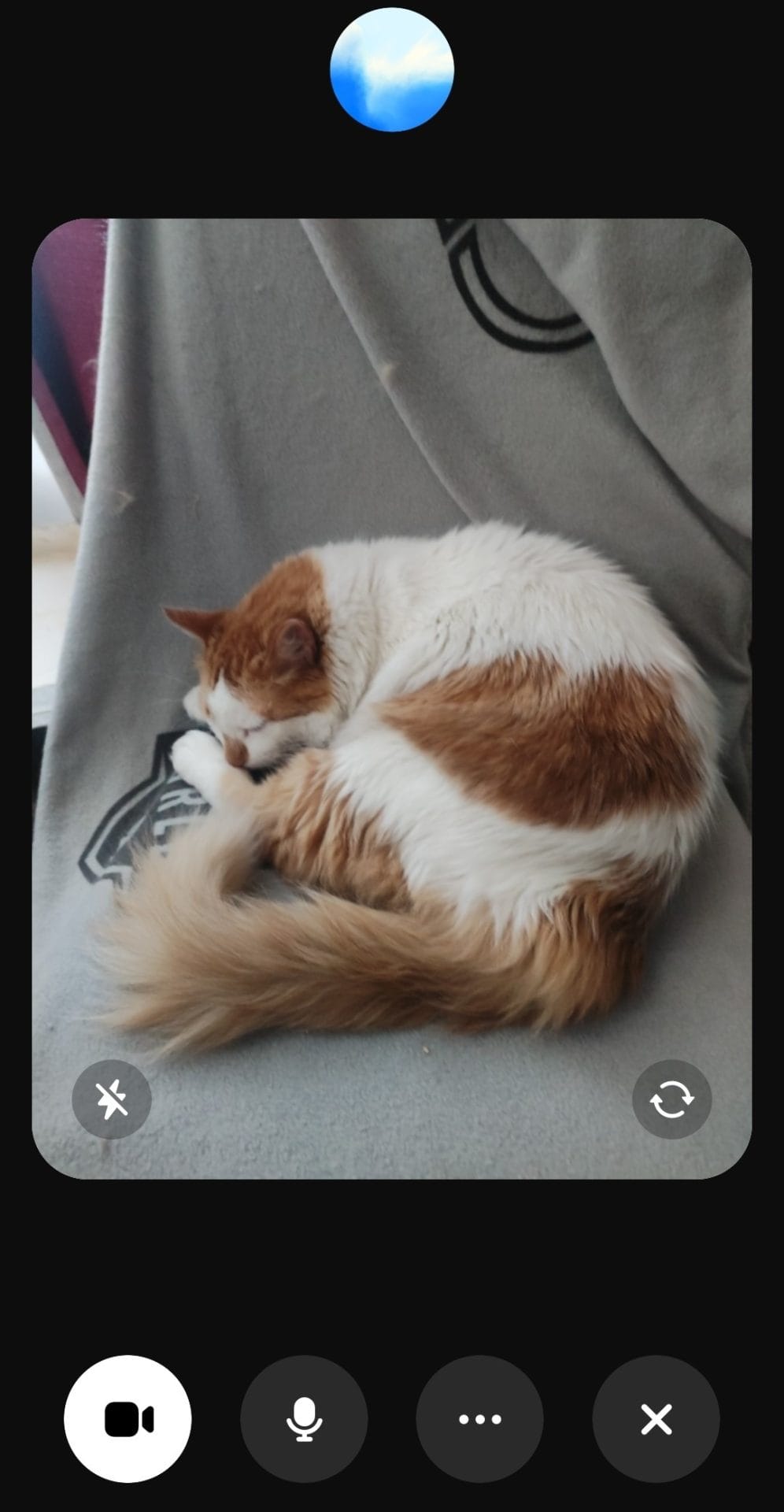

Tomando las funciones de video, es posible realizar preguntas al modelo ChatGPT 4o sobre lo que estás viendo, que puede ser algún objeto, animal o lugar. La aplicación tomará la cámara del dispositivo para iniciar una conversación respecto a tu entorno y responder de ese mismo contexto.

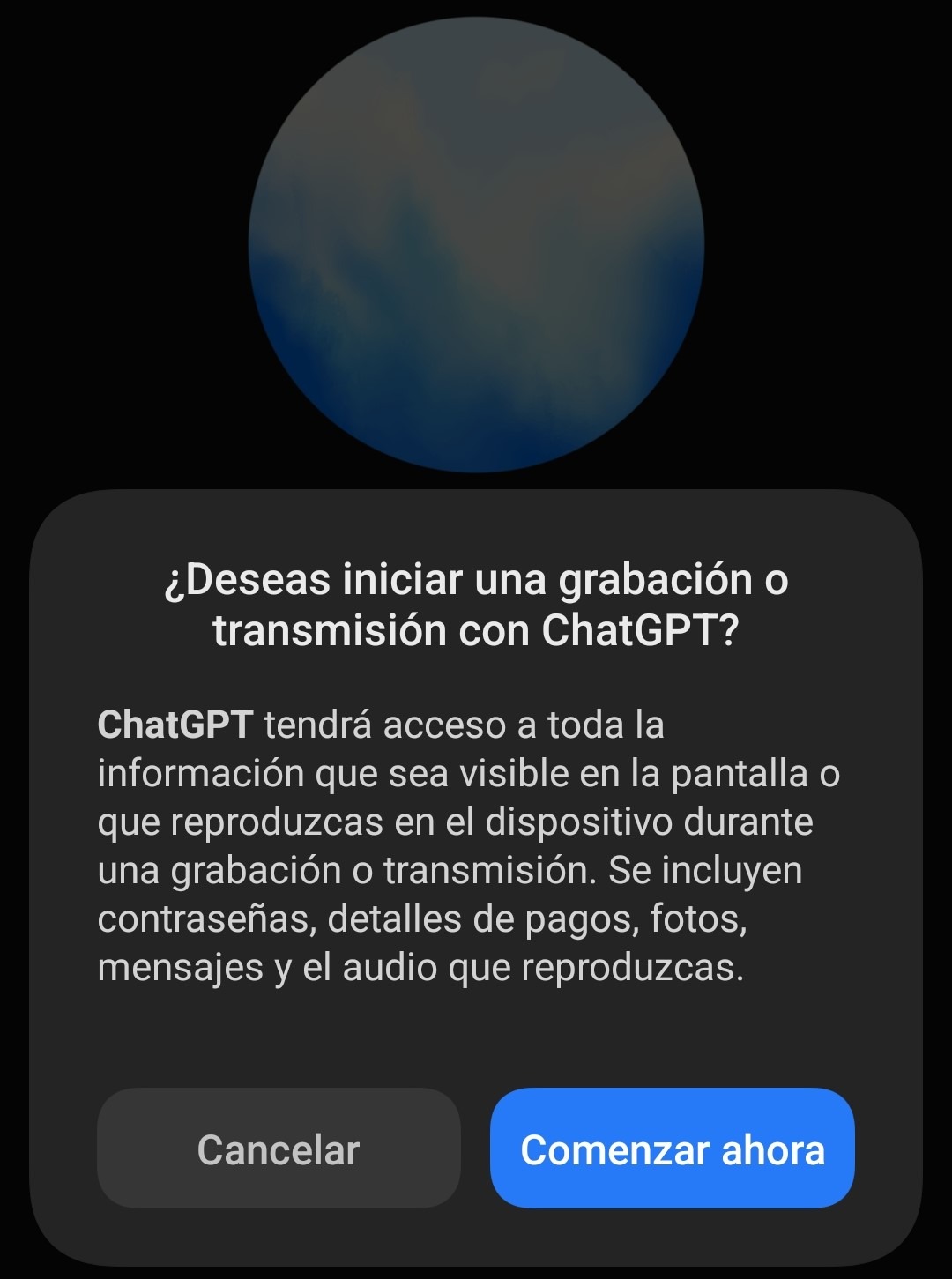

Para ocupar esta función, deberemos estar en el modelo ChatGPT 4o y seleccionar el modo de voz. Una vez ahí, podremos seleccionar el nuevo icono de cámara, que mostrará en pantalla todo lo que capture la cámara principal. Si tienes activo el micrófono, podrás tener una conversación con el Chat sobre lo que “está mirando” y preguntar cosas relacionadas con estas.

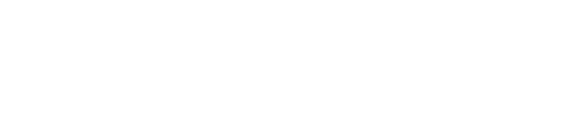

Por otro lado, si no hay una conversación en algunos segundos, la misma aplicación te dará comentarios sobre lo visible. También te permitirá cambiar entre la cámara principal como la frontal, así como también compartir la pantalla del móvil. Ten cuidado de no mostrar información sensible, ya que le permitirás que vea contraseñas, datos y todo lo que figure en pantalla.

Por ahora, este modo de “Ojos” solo es compatible con el modelo de ChatGPT 4o y no es posible activarla en la versión de escritorio para Windows. Se espera a que su disponibilidad con más modelos y dispositivos se agregue próximamente.

Cabe destacar que estas no son todas las sorpresas para ChatGPT. Durante finales de diciembre presentaron OpenAI o3, un modelo de razonamiento superior, que permitirá ejecutar tareas avanzadas como escribir un script de Python para resolver problemas y crear una interfase visual para mostrarlos. Según OpenAI, o3 tiene fecha de lanzamiento inicios de 2025.